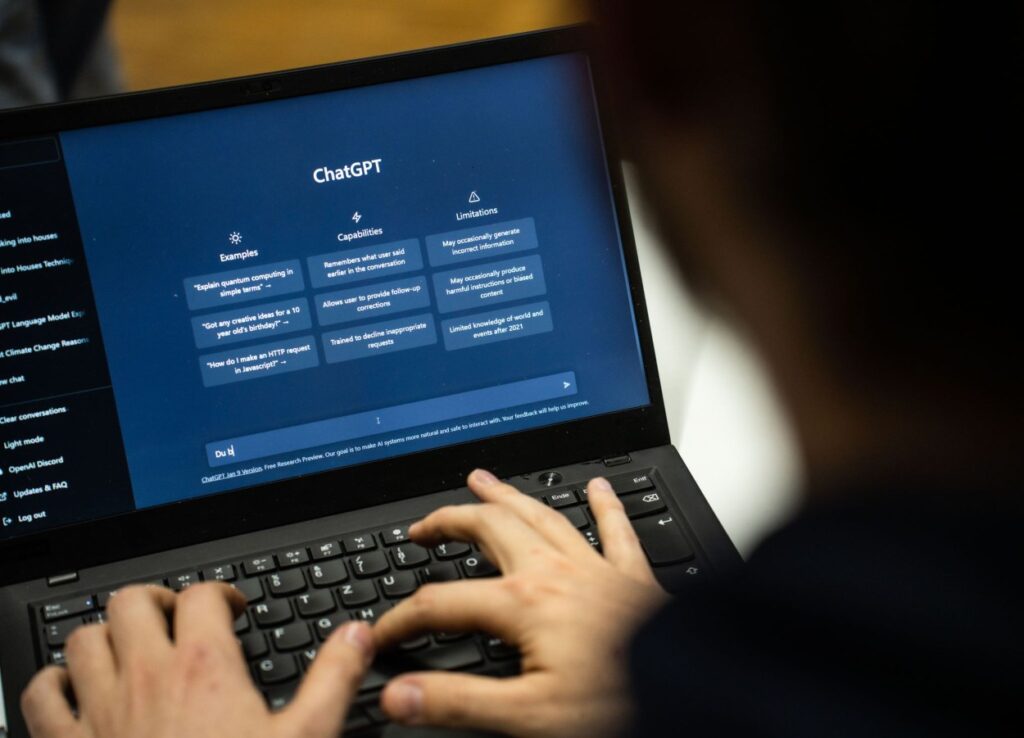

Përdorimi i chatbot-eve të inteligjencës artificiale gjeneruese (IA) po bëhet gjithnjë e më i përhapur në shumë sektorë, duke përfshirë menaxhimin e email-eve dhe mjetet e burimeve njerëzore, me qëllim rritjen e produktivitetit në ndërmarrje. Megjithatë, kjo praktikë sjell me vete rreziqe të mëdha në lidhje me ekspozimin e të dhënave. Një sondazh i fundit nga Aleanca Kombëtare e Sigurisë Kibernetike të SHBA-së (NCA) tregon se 38% e punonjësve ndajnë informacione të ndjeshme të punës me mjetet e IA, pa marrë lejen e punëdhënësve të tyre. Ky fenomen është më i theksuar te punonjësit e rinj, me 46% të gjeneratës Z dhe 43% të milenialëve që pranojnë se kanë ndarë informacione konfidenciale pa miratim, krahasuar me përqindje më të ulëta te gjeneratat më të vjetra.

Problemi kryesor është se këto chatbot-e mbledhin informacionin që përdoruesit vendosin në komandat e tyre, të cilat mund të përfshijnë të dhëna të ndjeshme si plane të brendshme, email-e konfidenciale apo të dhëna të klientëve. Ky informacion dërgohet në modelet e gjuhës së madhe (LLMs), ku përdoret për të trajnuar IA-në gjeneruese, dhe mund të bëhet i aksesueshëm në të ardhmen me komanda të përshtatshme. Një incident i njohur ishte ai i Samsung, ku ndarja e informacionit të ndjeshëm me një chatbot çoi në një shkelje të madhe të të dhënave. Edhe pse OpenAI, krijuesi i ChatGPT, paralajmëron përdoruesit që të mos ndajnë informacione konfidenciale, për shumë punonjës është e vështirë të jenë të vetëdijshëm për këto rreziqe gjatë përdorimit të përditshëm të këtyre mjeteve.

Një problem tjetër është mungesa e trajnimit. Sipas sondazhit të NCA-së, 52% e të anketuarve nuk kanë marrë asnjë trajnim për përdorimin e sigurt të IA. Ky hendek në njohuri ka çuar në përhapjen e të ashtuquajturës “IA e fshehtë”, ku mjetet e pa miratuara përdoren pa dijeninë apo miratimin e organizatave. Punonjësit, në përpjekje për të rritur efikasitetin, shpesh përdorin këto mjete pa kuptuar pasojat afatgjata për sigurinë e të dhënave apo përputhshmërinë ligjore, duke i ekspozuar organizatat ndaj rreziqeve të mëdha.

Për të zvogëluar rreziqet e sigurisë që lidhen me IA, organizatat duhet të zhvillojnë udhëzime të qarta për përdorimin e IA gjeneruese dhe të përcaktojnë llojet e informacionit që mund ose nuk mund të ndahen me këto mjete. Krijimi i kontrolleve të rrepta të aksesit, përdorimi i teknikave për maskimin e të dhënave dhe monitorimi i vazhdueshëm i përdorimit të këtyre mjeteve janë disa nga masat që mund të ndihmojnë në mbrojtjen e informacionit të ndjeshëm. Gjithashtu, auditet e rregullta dhe përdorimi i mjeteve të monitorimit të IA mund të sigurojnë përputhshmërinë dhe të zbulojnë përpjekjet e paautorizuara për aksesimin e të dhënave.

Në fund, është thelbësore që organizatat të shohin trajnimin jo vetëm si një kërkesë për përputhshmëri, por si një investim jetik për mbrojtjen e integritetit të të dhënave dhe markës së tyre.

Burimi: Shadow AI, Data Exposure Plague Workplace Chatbot Use/ Dark Reading/ https://www.darkreading.com/cyber-risk/shadow-ai-sensitive-data-exposure-workplace-chatbot-use